Climategate.nl kwam januari vorig jaar met een artikel over een promotieonderzoek dat het werken met en het denken over klimaatmodellen in een heel ander perspectief plaatst.

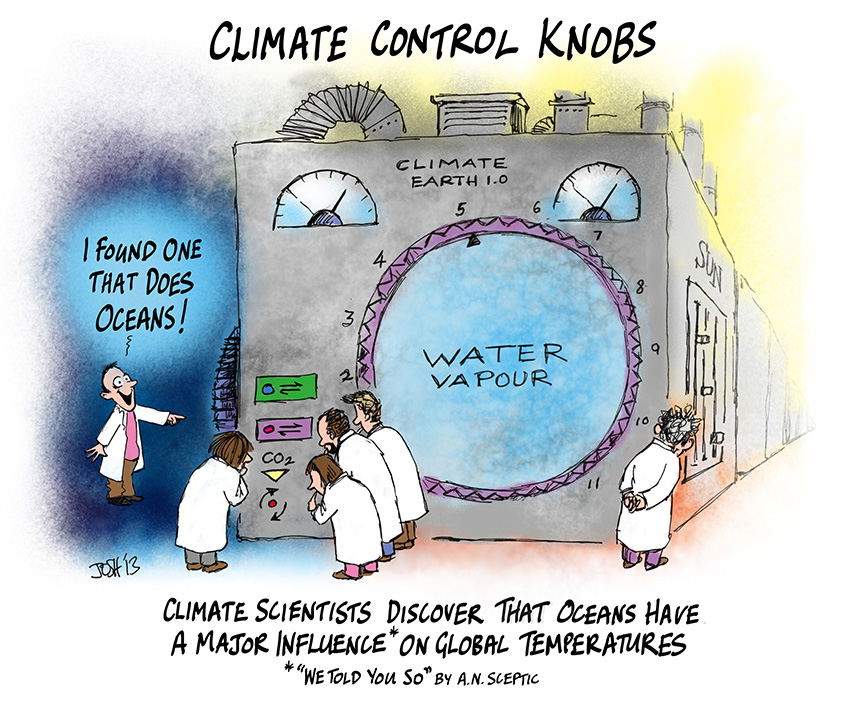

Voor we daarnaar kijken een stukje basisinformatie. Het klimaat en voornamelijk de temperatuurontwikkeling wereldwijd is van veel zaken afhankelijk waaronder CO2 maar ook van de oscillatie van de oceanen, de rol die oceaanstromingen spelen bij de warmteverdeling over de aarde, de werking van waterdamp, overheersende bewolking, aerosolen en zelfs grondgebruik zoals het verdwijnen van bossen en het uitgroeien van het stedelijk gebied etc. Het is dan ook een enorm ingewikkelde materie met veel elkaar beïnvloedende variabelen.

Om het klimaat, en dan met name de rol die CO2 daarin vervult, te kunnen bestuderen is het IPCC uitgegaan van vereenvoudigde modellen van deze werkelijkheid door aspecten waarvan ze denken dat de invloed minimaal is weg te laten. Vervolgens zijn die rekenmodellen vertaald in een of meer computermodellen waarmee men trachtte de toekomstige ontwikkelingen waaronder de mondiale temperatuurontwikkeling te voorspellen. Deze voorspellingen bleken er vaak naast te zitten. Ook een aantal aspecten zoals de stagnatie in de opwarming de afgelopen 18 jaar heeft men niet kunnen voorzien.

Wat je wel waarneemt nu is dat men de missers, met name zaken die in de praktijk anders bleken, of negeerde of met nieuwe modelberekeningen trachten te verklaren.

Een goed voorbeeld is het onderzoek van het KNMI naar de verdwenen warmte. Op grond van de modellen ging men er van uit dat er sprake moest zijn van opwarming zowel in de oceanen als in de atmosfeer en wat bleek: de opwarming stagneerde. Er werd weer een supercomputer van stal gehaald om dit te verklaren. Dat werd gedaan door er van uit te gaan dat de warmte er wel geweest moest zijn en op basis van deze vooronderstelling werden nieuwe modellen opgezet. En modelmatig is men op zoek gegaan naar de verdwenen warmte.

De conclusie na veel rekenen was dat een deel van de warmte extra kon zijn uitgestraald naar de ruimte en een deel verdwenen zou kunnen zijn naar de diepere lagen van de oceaan. De link geeft het onderzoek goed weer en wat zien we, men gaat modelmatig verklaren wat de oorzaak zou kunnen zijn dat de praktijkgegevens niet overeenstemmen met de eerdere voorspellingen.

Vervolgens gaat het KNMI nog een stap verder door te verklaren dat ze de verdwenen warmte gevonden hebben en brengen dat breeduit in het nieuws terwijl het echt niet meer is dan het resultaat van modelberekeningen.

Kijk maar eens naar dit bericht van het KNMI.

Als je verder leest kom je het volgende in dit bericht tegen: ‘Voor hun onderzoek ‘Op zoek naar de ‘verdwenen warmte’ in de bovenlaag van de oceaan’ hebben KNMI-klimaatwetenschappers Caroline Katsman en Geert Jan van Oldenborgh gebruik gemaakt van berekeningen met een state-of-the-art klimaatmodel in het ESSENCE–project. De beschikbare tijdreeksen van de temperatuurmetingen van de oceanen zijn namelijk te kort en de gegevens te onzeker.’

Het bovenstaande is een duidelijk voorbeeld hoe het klimaatonderzoek nu werkt namelijk voornamelijk op basis van simulatiemodellen waarmee de praktijk steeds weer wordt vertaald in nieuwe modelberekeningen. Zo komt de klimaatonderzoeker dan weer met ‘bewijzen’ dat de voorgaande berekeningen wel juist moeten zijn en vervolgens worden deze resultaten gepresenteerd niet als resultaat van een modelberekening maar als in de praktijk gevonden bewijs.

Terug naar het bericht op de site van Climategate. Het betreft een bericht over het promotieonderzoek van Alexander Bakker over de werking van klimaatmodellen en zijn conclusies zijn onthutsend. Dit is wat Climategate er over schrijft:

Over numerieke klimaatmodellen: je kan de vergelijkingen die de stromingen beschrijven van de atmosfeer en de oceanen aan elkaar koppelen, je kan bestuderen hoe die veranderen onder invloed van temperatuurschommelingen, je kan de invloed van wolken, sneeuw, en luchtvervuiling meenemen – maar je kan nooit controleren of je resultaten overeenkomen met de werkelijkheid.

Deze uitspraak komt uit onverdachte hoek: Alexander Bakker, KNMI’er en gepromoveerd op jarenlang onderzoek naar het nut en de noodzaak van klimaatmodellen. Hij doet in een artikel op kennislink.nl een aantal opmerkelijke uitspraken.

Zo constateert Bakker dat er te weinig gegevens uit het verleden beschikbaar zijn om de modellen goed te toetsen en af te stellen. Ook waarschuwt hij voor het GIGO–principe: modellen worden vaak onbewust zo geconstrueerd of aangepast dat ze aan verwachtingen voldoen: je krijgt eruit wat je erin stopt, en dus, Garbage In = Garbage Out.’

In het bericht op climategate ‘klimaatbeleid voor de bakker ermee’ is een link naar een artikel op kennislink opgenomen. Dat artikel geeft een goed beeld van de wijze waarop Bakker op grond van zijn promotieonderzoek naar klimaatmodellen kijkt.

‘Er valt niks te toetsen’, vat Bakker het grootste probleem van de klimaatmodellen samen. Wetenschappers kunnen de vergelijkingen die de stromingen beschrijven van de atmosfeer en de oceanen aan elkaar koppelen. Ze kunnen bestuderen hoe die stromingen veranderen onder invloed van temperatuurschommelingen en ook de invloed van wolken, sneeuw, en luchtvervuiling meenemen in de berekeningen. Maar onderzoekers kunnen nooit controleren of de resultaten de toekomst goed voorspellen, om de simpele reden dat die toekomst nog voor ons ligt. Wel is het mogelijk om te kijken of de modellen het klimaat uit het verleden kunnen nabootsen. ‘Maar we hebben bijna geen verleden’, zegt Bakker. De periode waar metingen van zijn is zo kort, en de metingen zelf zijn zo schaars, dat ook de reconstructie van het paleoklimaat voornamelijk een kwestie van interpreteren is.

Uiteindelijk leidt dit, meestal onbewust, tot modellen die vertellen wat de wetenschapper zelf al dacht, stelt Bakker. Als er iets uit het model komt dat tegen de intuïtie van de onderzoeker ingaat, zal deze het model immers vaak bijstellen of verwerpen. ‘En wat we uiteindelijk te zien krijgen is het eindresultaat. Hoe en waarom hete model ‘getuned’ is, wordt nauwelijks gedocumenteerd.’

Wat is de waarde van dit promotieonderzoek voor de toekomst? Ten eerste is het gehele klimaatverhaal en de alarmerende voorspellingen van het IPCC gebaseerd op klimaatmodellen. Dan zijn ze al jaren bezig om de uitkomsten af te stemmen op de werkelijkheid, wat niet echt goed lukt.

De stagnatie van de opwarming de afgelopen jaren is nooit goed zichtbaar in hun samenvattingen naar voren gekomen en men heeft deze stagnatie lange tijd ontkend en daarna alleen in bedekte termen naar buiten gebracht. Als laatste kwam het IPCC weer met een verklaring voor de hiatus op basis van modelberekeningen. Hun laatste boodschap was dat de verdwenen warmte terug te vinden moet zijn in de diepere lagen van de oceanen. En dat die over langere tijd (30 jaar) wel weer naar boven kan komen. Zo hou je een niet bewezen theorie in de lucht en je bent als klimaatonderzoeker zeker van je baan tot je pensioen.

Bron hier.

“Ik denk wel dat de aarde op gaat warmen – ergens tussen 0,5 en 10 graden. Noem me liever een klimaat–wetenschaps–scepticus. ” Aldus Alexander Bakker. Wat een troost jongens, wat een troost.

Ik denk dat er weer een ijstijd komt……… tussen nu en 10.000 jaar…..

Dank Hugo interessant onderzoek. “Uiteindelijk leidt dit, meestal onbewust, tot modellen die vertellen wat de wetenschapper zelf al dacht, stelt Bakker.” Ook Bakker onderzocht wat IPCC-critici al decennia dachten/weten.

Hugo, goeie samenvatting!

Je vergat te vermelden dat ze de waarnemingen trachten aan te passen aan de modellen om de pauze te doen verdwijnen. Maar zoals Christy in deze fantastische “testimony” laat zien geven de modellen voor de “bulk atmosfeer” 2.5 tot 3 maal sterkere opwarming te zien dan van de waarnemingen valt af te leiden. Het aardige van zijn benadering is dat de temperaturen van de troposfeer nauwelijks zijn te manipuleren in tegenstelling tot de oppervlakte temperaturen.

http://docs.house.gov/meetings/SY/SY00/20160202/104399/HHRG-114-SY00-Wstate-ChristyJ-20160202.pdf

Christy is beroepsleugenaar en nepwetenschapper.

“John Christy, the Ned Flanders of climate denial, appeared once again before a welcoming crowd at Rep. Lamar Smith’s House Science committee, in a show-hearing designed to whip up more impotent right wing rage against pointy headed intellectuals, their wacky left-wing climate science, and a suspiciously French global climate agreement.

Especially entertaining for me – Dr. Christy spent a good part of his time responding to stinging and long overdue critiques of his science, and his much ballyhooed satellite measures of global temperature, delivered by several of the world’s most respected atmospheric experts in my recent video.

Dr. Christy is one of those fortune-favored individuals who consistently make a name for themselves by “failing up”. It’s a time-honored path to success, celebrated in films like Forrest Gump, and Being There – and George W. Bush proved it will take you all the way to the Presidency. Christy has done it in the science world.

In a series of egregious errors in the 1990s and 2000s, Dr. Christy and his partner Roy Spencer, actually managed to read their satellite data as showing the planet cooling, a 180 wrongway boneheaded analysis, let’s call it “Freedom Science” – that they defended stubbornly for more than a decade, until the overwhelming weight of evidence forced them to admit they were wrong.

For ordinary people, blowing it that bad could be a career killer – but if you are telling climate deniers and wealthy barons of the world’s most profitable industry what they want to hear, it makes you the toast of Washington.

Certainly, if not for a rich history of bungling, error, and accompanying arrogance, no one would ever have heard of Dr. Christy. But in these confusing times, for a science-challenged and ideologically blindered audience, Dr. Christy is science denial’s enthusiastic go-to guy, and a hero to intellectual titans like Ted Cruz, Rush Limbaugh, and Lamar Smith.

Below, if you have not seen, the satellite video that’s gotten under Dr. Christy’s skin.”

http://climatecrocks.com/2016/02/04/satellite-scientist-upset-at-well-funded-video/

Ben je van het padje af, Dorpje, want Christie is op de echte kritische klimaat analytische blogs geheel in het gelijk gesteld . “John Christie proved that the models with the highest climate sensitivity are also the ones which are the worst at predicting future temperatures.” Je bent toch niet in verwarring met John Christie de serie moordenaar? http://wattsupwiththat.com/2012/09/21/dr-john-christys-testimony-before-congress/

Gaap.

Joris je bent weer goed op dreef. Je laat je wel in de kaart kijken

Kun je het op basis van wetenschappelijke argumenten niet verklaren dan gaan je als warmist over tot persoonlijke aanvallen.

Duidelijk een vorm van straatvechten als ze het daarmee willen winnen is wat klimaatwetenschap genoemd wordt meer te vergelijken met voodoo.

Wie nu nog steeds niet doorheeft dat Christy en Spencer al decennia lopen te klungelen met hun *modelvorming* ten behoeve van het genereren van temperatuurreeksen afgeleid uit satelietmetingen, daarmee is geen zinnige discussie te voeren.

http://4.bp.blogspot.com/-u7lITwAd1Ec/UwZC3oS1-2I/AAAAAAAAC_U/Vhlfl35TFG8/s1600/Christy+Spencer+temperature+trends.tif

Joris, Als je kritiek hebt op de temperatuurreeksen van Christy en Spencer , hoe denk je dan over de alarmist Carl Mears van Remote Sensing Systems (RSS)?

Ha! Als die computermodellen dan toch zo onfeilbaar zijn, waarom worden die dan niet eens ingezet om de invloed van de asieltsunami te voorspellen? Want immers, dat gaat ook van 400 ppm naar 1.000 ppm en dat maar liefst in een paar maanden ipv 100 jaar. And counting.

Kosten ppm schijnen ook nog iets van 30.000 per jaar te zijn.

Das ietsje duurderder dan 1 ppm CO2. Dus vandaar.

Derhalve de vragen:

1. Met een dergelijke stijging van ‘verhitte gemoederen’, hoeveel zal de zeespiegel stijgen?

2. Helpt ‘wegkijken’ of ‘politieke correctheid’ of ‘cultureel marxisme’ tegen deze zeespiegelstijging? En zo ja, hoeveel mm per jaar/cm per eeuw scheelt dit?

3. And dear Watson, kunt u verklaren waarom ‘verhitte gemoederen’ de aarde niet opwarmen maar een laagje van 16 cm man-made CO2 in de troposfeer wel?

4. En Watson, nog een vraagje: denkt u dat een koude oorlog 2.0 met Rusland de aarde zal afkoelen, want dat suggereert het woord ‘koude’, of is het tegenovergestelde juist het geval? Want zoals u weet, wordt er hard gewerkt om de grenzen met Rusland te versterken. Want u weet wel, Poetin = bedreiging= reuze schurk=gevaar enzovoorts. U volgt het journaal toch wel? Nou dan.

5. Kunt u voorspellen wat het break even point is van de kosten/baten van de asieltsunami? Oftewel: bij hoeveel ppm zal er een economische meltdown plaatsvinden? Zeg maar ‘verzadigingspunt’.

Afijn dear Watson, vragen, vragen, vragen.

Als de warmte nu deels in de oceanen is verdwenen, dan is die er tussen 1975 en 1998 blijkbaar uitgekomen, de menselijke bijdrage was dus minder.

Wat ik mis: de invloed van onderzees vulkanisme. Tienduizenden vulkanen staan er op de oceaanbodem. Die zouden wel eens de belangrijkste factor kunnen zijn van klimaatverandering.

De vraag blijft: welk mechanisme maakt dat tot 1998 de warmte in de lucht verdwijnt en daarna in het water? Waarom daarvoor niet ook?

https://judithcurry.com/2016/01/24/undersea-volcanoes-may-be-impacting-long-term-climate-change/.

het leest alsof temperatuurstijging zorgt voor meer zeewater en dus voor meer druk op ondergrondse vulkanen en dus voor minder erupties en dus minder co2 uitstoot. en andersom natuurlijk. geen idee of oorzaak en gevolg kunnen zijn omgedraaid. zijn er toevallig experts in de zaal?

Ook een mooi voorbeeld wat het naar je hand zetten van modelberekeningen betreft is de studie van dr Ummels over de inpassing van windenergie op ons stroomnet.

Dat was de basis van de voorlichting over wind energie in 2010.

Dit schrijft hij er zelf over:

Energie-Opslag Niet Nodig

Mijn onderzoek wijst verder uit dat er geen voorzieningen voor energieopslag hoeven te komen. Voor het technisch functioneren van de elektriciteitssysteem is zo’n extra buffer niet nodig, en met de enorme investeringskosten is het ook niet rendabel. De resultaten geven aan dat internationale elektriciteitshandel een veelbelovende en goedkopere oplossing is voor de inpassing van windenergie. Netbeheerder TenneT is inmiddels met de proeven gestart met een flexibelere internationale markt met Duitsland. Ook het flexibeler maken van bestaande elektriciteitscentrales is een betere oplossing. Het gebruik van warmteboilers zorgt bijvoorbeeld voor een flexibelere bedrijfsvoering van warmtekrachtcentrales, die daardoor ’s nachts ruimte kunnen maken voor wind.

Helaas voor hem is de praktijk toch wel anders het grootste probleem met wind energie op dit moment dat we niet in staat zijn voldoende opslagcapaciteit te realiseren om ons vraaggestuurde net daarmee in de lucht te houden.

En dwaallicht Kamp geeft in een brief aan de kamer aan dat alleen met modelberekeningen de productie- en inpassing van windenergie is vast te stellen.

Met andere woorden modellen zijn er om je beeld van de praktijk te toetsen en zolang de resultaten niet getoetst kunnen worden in de praktijk is het uitgaan van modelberekeningen alleen zeker geen wetenschap meer maar het domste wat je kunt doen.

Ps

De link naar de visie van Ummels

https://www.olino.org/articles/2009/04/02/windenergie-the-sky-is-the-limit/

Mr. Ummels heeft de mogelijkheid van gedeeltelijk uitschakelen van windmolens niet genoemd bij overproductie. Bij groei van het windmolenpark volgens het energie accoord zal die situatie zich voordoen. En wie gaat de verloren inkomsten van de molenaars betalen?

Zijn proefschrift braakt van de gemiddelde windsnelheden.

Fundamentele denkfout omdat elk type turbine een minimale windsnelheid nodig heeft.

Stel (dus voorbeeld) dat de cut-in snelheid 4 m/s is en de windsnelheid in een gegeven periode 0, 1, 5, 8, 9, 4, 3 m/s is.

Het gemiddelde is 4.29 en volgens Ummels levert de turbine dan gedurende de hele periode energie.

Helaas, 3/7 van de tijd is de windsnelheid kleiner dan de cut-in snelheid en moet de energie van elders komen.